Le passé et l’avenir de la photographie

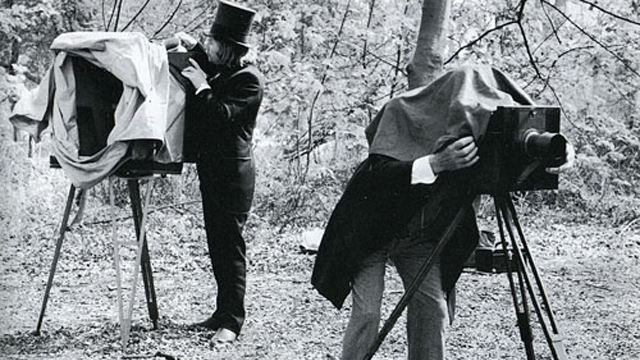

Début de la photographie

Louis-Jacques-Mande Daguerre, inventeur du procédé photographique.

En opposition à l’industrie des peintres portraitistes, un groupe d’artistes influents qui vivait de la production de portraits se sont opposés à l’apparition des techniques reliées à la production photographique.

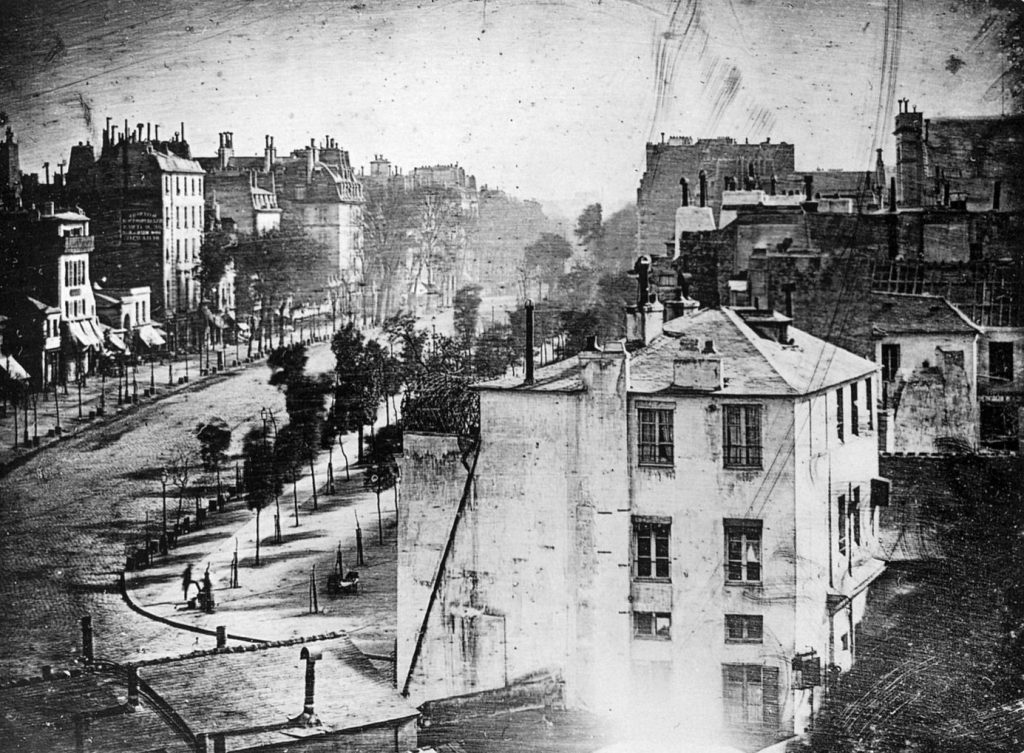

Première photo documentée avec sujet humain, prise en 1838 sur le boulevard des Temples. La longue exposition de 10 minures requise pour produire le cliché a fait disparaitre tous les personnage et le traffic de la rue, à l’exception des deux personnages immobiles, ce qui représentre la première photo extérieure avec des humains présents.

Le boulevard des Temples, aujourd’hui

Le procédé Daguerre ne réussit pas à s’imposer, à cause des coûts de production élevés, de problèmes de licence, du fait qu’il ne permet qu’une seule image positive (pas de reproduction à partir d’un négatif). En effet, le cliché obtenu était un positif sur une plaque métalique, qui était le produit final. Ce processus est basé sur l’utilisation d’une surface de cuivre polie couverte d’oxyde d’argent préparée avec des fumées pour la rendre sensible à la lumière.

Une technologie de remplacement s’est plutôt imposée: le processus de collodion humide, découvert par l’inventeur britannique Frederick Scott Archer au début des années 1850. La méthode nécessite l’utilisation d’une plaque de verre avec un revêtement chimique baignant dans une solution de nitrate d’argent. Cette plaque encore humide est placée dans l’appareil photo. Le procédé daguerréotype permet de produire des images de grande précision mais sans produire un négatif: l’image finale est le positif. Bien que le processus de collodion était un procédé très fragile (car les plaques humides devaient être chargées dans l’appareil , exposée aux aléas tels poussières, égratignures qui pourrait ruiner l’image), la plaque résultante est un négatif et permet de faire des impressions. Le temps d’exposition d’une plaque utilisant le procédé de collodion humide est de 2 à 5 minutes en studio, ce qui oblige les personnages à demeurer immobile en utilisant des poses et des artifices pour réduire les risques de mouvements causant des images floues.

L’influence de Kodak

George Eastman lance Eastman Kodak qui devint la plus grande entreprise mondiale de produits photographiques, basée à Rocherster, avec plus de 60,000 employés de production, des chimistes, de chercheurs et un réseau de distribution mondial.

Démocratisation de la photographie du type rasoir/lames, appareil peu couteux, facile d’usage, encourageant chaque famille a avoir son appareil. Pendant près d’un siècle, Kodak domine le marché mondial de la photographie, en terme de production de films, de papiers d’impression, de caméras et d’applications industrielles. L’ensemble des ses activités sont basés à Rochester, dans l’état de New York.

Appareil Brownie, facile d’usage et présent dans tous les foyers nord-américains pendant près de 70 ans, a partir du début du XXe siècle.

Contre toute attente, la compagnie frôle la faillite et se place sous la protection du Chapter 11 entre 2009 et 2013. Elle en ressort affaiblie et l’ombre de ce qu’elle était à son apogée. Pour se refinancer, elle liquide pour un total de 950 millions de propriété intellectuelle et réduit ses activités à quelques secteurs industriels.

Discussion

Comment expliquer que le procédé argentique, aussi perfectionné qu’il était, puisse disparaitre aussi rapidement, au main d’une technologie en émergence, le numérique, qui au début donnait des images de qualité médiocre?

1950 : apparition de la caméra réflex 35 mm, puis du posemètre intégrée, un format qui dominera le marché des consomateurs pour une période de 50 ans.

Utilisation d’un posemètre

Les posemètres utilisent un capteur photo-sensible qui produit un signal électrique en fonction du flux lumineux qu’il reçoit.

Sur les posemètres indépendants, ce capteur est situé derrière une fenêtre transparente qu’on oriente vers la scène pour une mesure en lumière réfléchie, ou bien derrière un diffuseur translucide plat ou hémisphérique (sphère intégrative) pour une mesure en lumière incidente.

Lecture de la lumière incidente

Une cellule photoélectrique, généralement recouverte d’une boule en plastique translucide recueille la lumière incidente à laquelle le sujet est exposé et en mesure l’intensité. Le posemètre calcule alors les paramètres d’exposition optimale en fonction des variables de prise de vue (vitesse d’exposition, ouverture de diaphragme, sensibilité du capteur numérique). La mesure est effectuée à l’emplacement du sujet et dans les conditions d’éclairage auxquelles il sera exposé pour la prise de vue, la sphère intégrative doit être dirigée dans l’axe optique de la caméra. C’est donc un appareil de mesure indépendant de celui de prise de vue.

Lecture de la lumière réfléchie

En mesure réfléchie, le posemètre analyse la quantité de lumière réfléchie par le ou les sujets visibles par la surface sensible et calcule les variables d’exposition. En fonction de normes définies, ils calculent la quantité de lumière moyenne devant impressionner la surface sensible.

Photomètre

Système de zones par Ansel Adams

Le coût de démarrage d’un studio

Circa 1960, un photographe démarrant sa pratique achetait son équipement pour la vie, qui gardait sa valeur, investissement sur la qualité de l’optique

Révolution du numérique

L’apparition des premières caméra numérique performantes se fait au début des années 2000. En 2005, un appareil professionnel pouvait fournir une photo de 6 Mb, ce qui suffisait à peine pour offrir une résolution suffisante pour produire un ‘spread’, un double page de magazine.

Discussion

Quelles fonctions des caméras numériques ont entrainé une migration aussi rapide de l’argentique vers le numérique?

Quelles sont les fonctions les plus novatrices d’une caméra numérique moderne?

DSLR: Digital See-through Lens Reflex

Après 2008, les profils de couleurs (RGB, Adobe) sont standardisés et utilisés par les manufacturiers de caméras numérique, les outils logiciels de traitement de l’image tel Photoshop, par les manufacturiers (écrans, projecteurs, imprimantes) et services d’impression. Ces profils agissent comme des interprètes des normes de couleur qui permettent de standardiser la précision des teintes.

Apple a lancé récemment l’usage d’un capteur pour mesurer la couleur de la lumière ambiante et les conditions lumineuses pour ajuster l’écran des iPads pour permettre à l’observateur de voir les couleurs de façon constante, peu importe l’intensité et la température ambiante de la lumière. Cette technologie est connu sous le nom de ‘True Tone’.

Définition

La photographie computationelle (en anglais Computional Photography / Je suis à la recherche d’un meilleur terme pour définir la technologie en français), ou imagerie computationelle fait référence à un processus de capter des images numériques en utilisant des techniques de transformation basées sur le calcul numérique au lieu d’un processus optique. La photographie computationelle peut améliorer les capacités d’un appareil photo, ou introduire des fonctions qui ne sont pas possible avec les processus de photographie optique. Voici quelques exemples d’application de la photographie computationelle avec des images faites par traitement de la caméra: production d’images panoramique 360 degrés, production d’images HDR avec gamme dynamique élargie, production d’images tridimensionnelles, amplification de la profondeur de champ, le recalcul de la mise au point (de-focus).

Quel est l’avenir de la photographie et de la technologie?

Depuis les débuts de la photographie il y a presque 180 ans, la relation entre le photographe et un appareil photo est demeurée essentiellement inchangée. Vous ouvrez l’obturateur et capturer une image. Bien que vous pouvez changer l’objectif, l’exposition et le traitement de l’image et des pixels, on peut dire qu’il y a une relation directe entre ce que vous avez vu et ce que l’objectif a capté. Mais vous avez probablement produit des milliers, voire des dizaines de milliers de photos au cours des dernières années en brisant cette relation sans le savoir.

La photographie computationelle prend un essaim de données à partir d’images ou les capteurs d’image et les combine algorithmiquement afin de produire une photo qui serait impossible à saisir avec l’argentique ou la photographie numérique en sa forme plus conventionnelle. Les données d’image peuvent être assemblées à travers le temps et l’espace, permettant ainsi la production de super-haut de gamme dynamique (HDR) photos, ou bien une seule image qui capture à la fois les zones claires et sombres. Plusieurs caméras d’entrée de gamme peuvent être fusionner plusieurs images en une seule, incluant certains téléphones tels les Androides et l’iPhone 7. Cette technologie permet de capter une image plus riche ou un zoom synthétique qui semble presque aussi bon qu’une image produite avec une optique traditionnelle.

Mais bien que la photographie computationelle commence à s’imposer au quotidien dans nos appareils du type smartphones et certains appareils photo numérique autonome, nous en sommes encore au tout début de la révolution. Google, Facebook, et d’autres poussent le concept plus loin, et les chercheurs dans le domaine nous disent qu’il y a plein de nouvelles technologies en développement qui feront certainement la transition dans nos caméras pour permettre une production d’images novatrices.

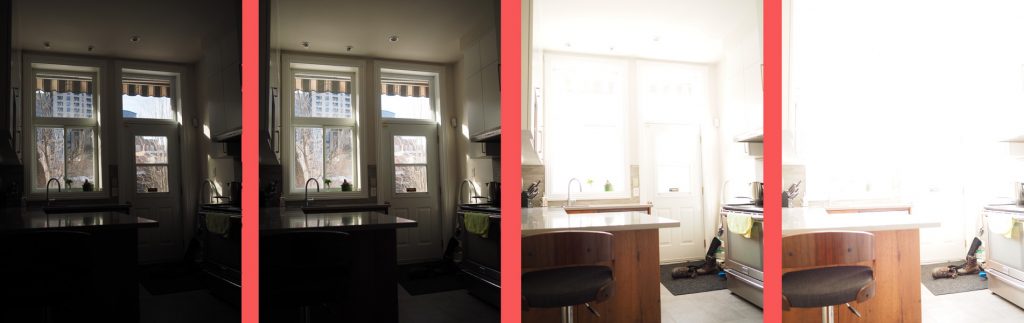

Exemple HDR de 6 photos basées sur la variation de l’ouverture du diaphragme, avec vitesse et ISO fixes.

Image composite résultante des 6 expositions

Exemple HDR de 8 photos (seulement 4 sont présentées) avec un objectif macro qui offre une profondeur de champ minimale et variation automatique de la mise au point

Image synthétique résultante

La prise de vue d’images panoramiques offre une fonction similaire: l’appareil recompose une vue composite de plusieurs photos prises en séquence.

Les prochains développements vont permettre la capture d’objets 3D, de capture vidéo et l’analyse de la réalité virtuelle et la réalité augmentée, une meilleure interaction en temps réel, et même des autoportraits en mode RA qui seront plus ressemblants.

La vision 360

La production de photos en mode continue avec de l’équipement photographique embarqué et synchronisé est une innovation qui a changé notre relation avec l’espace urbain. L’équipement permet d’obtenir une vision synthétique et continue dans un espace capté par les caméras. L’observateur peut naviguer

Depuis, le système de captation a été miniaturisé et est utilisé a de fins multiples, incluant la visite de musées, d’espaces publics. Les compagnies s’en servent pour présenter leurs espaces de travail enfin de valoriser le lien client et employé. La technologie permet de faire une visite virtuelle d’une propriété, ce qui illustre le potentiel commercial de ces technologies.

Capture en mode continue 360 degrés

Les deux leaders dans le domaine sont le Jump de Google et Facebook 360.

L’intelligence artificielle à la rescue

Les équipes de Google Brain, le laboratoire de Machine Learning du géant américain, travaillent sur deux systèmes de neurones artificiels. La première consiste à analyser une photo en très basse résolution (ici 8 pixels par 8) et de la comparer à d’autres photos en haute qualité stockée dans une base de données pour obtenir une première image plus nette de 32 x 32. Cette seconde image passait une nouvelle fois à la moulinette pour utiliser des clichés en haute résolution pour reconstruire l’image encore plus finement. Si, dans les exemples donnés par Google, on est encore loin d’atteindre une qualité haute définition pour les images ainsi obtenues, il faut tout de même saluer le bond de qualité effectué par rapport à l’image de base.

L’utilisation de l’AI permet de construire une image détaillée à partir d’une photo en très faible résolution. Ici on passe de 8×8 pixels à une résolution de 32×32 pixels. Cette transformation se valide à partir d’une base de données d’images comparables qui permet l’apprentissage pour fournir une interpréation plus juste.

Google indique qu’il lui reste encore pas mal de travail pour obtenir des images encore plus fines.

Les caméras des téléphones intelligents envahissent le marché des caméras traditionnelles

Au cours des dernières années, nous avons vu une transition entre une photo smartphone ‘acceptable’ vers la production d’une photo qui impressionne, envahissant ainsi le marché des appareils photos numériques de niveau consommateur. Les smartphones ne peuvent pas égaler la qualité d’une image avec une caméra avec un objectif haut de gamme et un capteur de haute résolution, ils continuent d’élargir leur part de marcher avec une qualité d’image croissante et l’apparition de la photographie computationelle.

L’apparition des téléphones intelligents performants pour la prise de photos

Lorsque le HDR est apparue pour la première fois avec l’iPhone iOS 4.1 sortie en 2010, il a permis de traiter les images de la même façon qu’une caméra professionnelle : prendre plusieurs images manuellement ou avec les paramètres automatiques à différentes expositions ou d’autres paramètres. Avant l’apparition de logiciel d’édition d’images, les photographes devait choisir parmi leurs photos et utiliser des techniques de chambre noire pour les combiner. Photoshop et d’autres logiciels tel Photomatic ont permis d’automatiser le processus d’expositions multiples. Cette fonction est apparue avec l’IOS 4.1 en mode automatique.

Avec la fonction HDR intégrée dans un smartphone, même si les premières versions n’étaient pas excellentes (Android a suivi l’exemple de l’iPhone et l’a ajouté comme fonction de base), la pratique est devenue monnaie courante et la capacité des téléphones s’est grandement améliorée. A ce jour, la majorité des efforts de recherche en sont resté à ce point, en partie avec les contraintes physique du format, la capacité du processeur et de la batterie.

L’ajout de plusieurs caméras est apparue en 2014. Avec l’arrivé de l’iPhone 7 Plus de Apple (octobre 2016) offre un grand-angle et téléobjectif qui opère comme une paire synchronisée. De cette façon, on peut capturer simultanément différents aspects de la même image, avec la capacité de traitement qui donne un résultat final de qualité supérieure.

Avec deux caméras synchrones et le logiciel qui effectue la reconnaissance d’objets dans la scène, il devient possible d’extraire la profondeur de champ. L’iPhone 7 Plus utilise cette technologie en mode beta pour la production de portrait. La caméra dissocie l’arrière-plan de l’avant-plan, ce qui permet de rendre l’arrière plan flou et créer un effet de dissociation et de profondeur. Ce processus simule ce qu’un photographe aurait obtenir en utilisant un reflex numérique couplé avec un objectif avec une très courte profondeur de champ (ouverture f / 1.8 ou plus grand).

On réfère a cette différenciation entre le sujet et le fond comme l’effet Bokey. On peut avec des apps standardisés dans Photoshop créer du faux Bokey. De la même manière, la caméra Apple 7 Plus avec 2 objectifs autonomes produit en temps réel du faux Bokey.

Portrait de Marc Hervieux capté avec iPhone 7, offrant une qualité d’image et de résolution impécable avec effet faux-bokey capté dans les studios de Radio Canada par Julien Faugère.

La capacité de dissocier l’image selon différents plans permet d’améliorer une image. Par l’analyse des objets selon la profondeur de champ avec un système de deux caméra peut améliorer l’image, avec l’intégration de la reconnaissance des visages.

Compétitions internationales de phots prises par téléphones inteligents (principalement de iPhones)

IPPA Campagne mondiale de promotion des fonctions photographique d’iPhones, associée à une campagne de publicité mondiale.

Mobile Phone Awards Jury indépendant

Un c’est bien, deux c’est mieux

Mais si deux objectifs/caméras est mieux, surement que plusieurs caméras sur un même appareil est meilleur ! Des chercheurs ont testé des caméras multi-ensemble en utilisant le ‘Stanford Multi-Camera Array, qui utilise 128 caméras différentes. Ce sont des installations fixes qui ne sont pas utilisable pour des fins commerciales.

Le faible coût et la petite dimension des objectifs du smartphone et l’apparition de logiciels de synthèse visuelle permettent d’entrevoir un avenir pour ces technologies. Au lieu d’utiliser un seul objectif dispendieux monté sur un reflex, l’exécution de calcul sur des photos recueillies auprès de nombreuses petites lentilles et intégrer les résultats des calculs pourrait offrir des résultats de haute qualité. C’est le cas par exemple de la caméra Light L16. C’est un appareil photo avec 16 appareils photo avec trois focales. (Au coût de $1,700, ce prototype n’est pas encore vendu commercialement)

Caméra Light L-16

Gallerie d’images produite par la caméra Light

Selon l’éclairage et le facteur de zoom, le L16 utilise différentes combinaisons de 10 de ces lentilles à travers trois focales afin de produire une image finale de 52 mégapixels avec un boitier de la taille d’un smartphone. Reste à voir ce que cet appareil peut vraiment accomplir, quand il sera dans les mains des photographes.

Le défi de la mise au point

Une autre approche nous est fourni par la compagnie Lytro, un appareil photo à objectif unique qui pourrait refaire la mise au point d’une photo après qu’elle ait été prise et produire ainsi des images 3D. La technologie Lytro s’appuie sur un large capteur d’image, dont les éléments ont été regroupés en super-pixels qui permettait à son logiciel pour capturer un champ lumineux, connaissant le sens entrant de la lumière qui atteint le capteur. Ce champ pourrait être reconstruit par le logiciel plus tard. A ce jour, le système n’a jamais vraiment livré les résultats attendus, ni dans sa version originale ou dans les versions professionelle. La compagnie est un start-up de $50 millions.

Caméra Lytro

Galerie de photos captées par la caméra Lytro

A ce jour, l’expérience Lytro n’a pas vraiment donné les résultats attendus. Aujourd’hui sur Amazon, on retrouve 16 caméras usagées à vendre a partir de $3,500

Le Saint Graal de la photographie: la 3e dimension

Plutôt que de capter la lumière ou produire une combinaison d’images, certains travaux expérimentaux cherchent a synchroniser les capteurs infrarouge (IR) qui permet de capter l’information en tenant compte de la profondeur. L’initiative Tango de Google permet de capter la lumière structurée et temporelle. La lumière structurée permet de projeter une structure qui permet d’estimer la profondeur et le déplacement des objets.

Le capteur Kinect de Microsoft utilisé avec la Xbox capte une lumière structurée et le mouvement dans le but de capter le déplacement en mode interactif avec un jeu.

Toute technique qui cherche à capter la notion de profondeur d’une image nous amène vers la réalité augmentée et la réalité virtuelle, en permettant à une caméra mobile de mieux identifier ce qui se trouve dans le champ visuel. L’avantage immédiat de la réalité augmentée est de permettre de superposer sur une image avec de l’information complémentaire nécessite beaucoup moins de capacité de traitement du processeur. En comparaison, une image de réalité virtuelle en mode 3D en temps réel nécessite une capacité de traitement très grande.

Dans l’avenir, la capture photographique de réalité virtuelle en mode 3D sera surement possible en intégrant les caméras multiples et le calcul de profondeur. Cependant, nous sommes encore loin d’avoir des solutions fonctionnelles.

Résoudre des problèmes quotidiens

Laissant de côté les capacités de RA et de RV, la photographie numérique peut nous aider à résoudre les problèmes courants, en intégrant la vision numérique (l’analyse automatique de l’image selon les perceptions) et l’apprentissage machine (l’entrainement de la machine a reconnaitre de qu’elle voient). L’objectif de l’imagerie computationelle cherche à extraire la géométrie d’une scène afin de permettre des analyses dimensionnelles.

Cet approche nous mène directement dans des domaines de pointe: vers le traitement des images en temps réel, dans le domaine de la robotisation et des véhicules autonomes.

Les équipements de l’avenir du photographes seront dérivés des grands projets de recherche en imagerie, incluant la vision robotique, le jeux vidéo interactif, la cartographie visuelle des espaces, la conduite automatique des véhicules. Ces grands crénaux de developpment nécessitent des capacités visuelles nouvelles, des caméras ultra-performantes et une capacité de traitement spectaculaire des données en temps réel.

Sous peu, les manufacturiers d’équipement photographiques sauront recupérer ces avancées technologiques pour les introduire dans nos équipement photo.

Utilisation de la technologie lidar à la photographie

Le lidar est une technologie développée pour créer une vision environnementale complète à 360 degrés pour une utilisation dans les véhicules autonomes, les équipements industriels, l’architecture, la cartographie 3D et la surveillance.

En 2019, Nikon a investi la somme de $25 millions dans la compagnie Velodyne pour la possibilité d’utiliser la technologie dans le calcul des distances.

En 2018, il s’est vendu 1.3 millions d’unités lidar. On s’attend à atteindre 6 millions d’unités en 2023. Cette croissance rapide démontre à quel point l’intégration de cette technologie sera important dans les années à venir pour le déploiement de la vision spatiale.

No Comments